No campo dinâmico da inteligência artificial, os Large Language Models (LLMs) surgem como uma das tecnologias mais transformadoras do cenário atual, movendo-se rapidamente da teoria à prática com implicações massivas no processamento de linguagem natural (NLP) e além. Uma típica representação dessas inovações é a recente introdução da Google DeepMind com a Diferenciável Cache Augmentation, um coprocessador que aprimora o raciocínio e a eficiência dos LLMs. Neste artigo, vamos explorar esse desenvolvimento com um olhar atento à arquitetura, analisar benchmarks de performance e discutir aplicações práticas no mercado brasileiro.

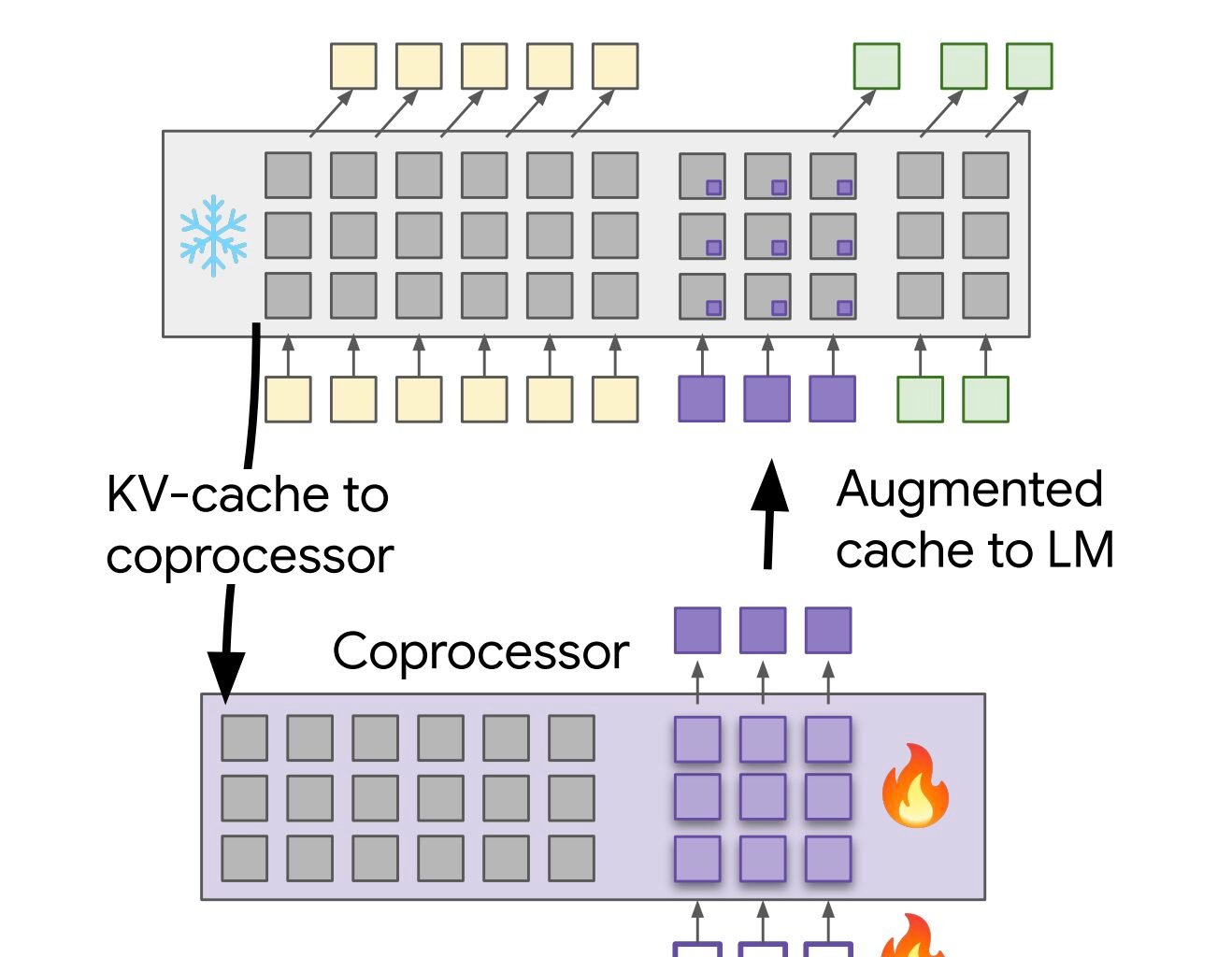

Arquitetura e Funcionamento

Os LLMs como GPT e sua família revolucionaram a maneira como as máquinas compreendem e geram linguagem. A arquitetura destas redes neurais é composta por várias camadas de atenções multi-cabeças (multi-head), que permitem ao modelo focar em diferentes partes de uma frase ou documento simultaneamente. Essa abordagem se traduz em uma capacidade sem precedentes de compreensão contextual e geração de texto.

A novidade da Google DeepMind reforça essa habilidade com um coprocessador diferenciado que pode ser visualizado como um auxiliar do LLM padrão, armazenando e recuperando informações de forma otimizada. Essa arquitetura permite que os modelos realizem tarefas mais complexas de raciocínio com maior eficiência, um avanço importante não só em termos de velocidade mas também de capacidade de resposta contextual mais fina.

Análise Comparativa

No que diz respeito ao benchmarking de performance, o Differentiable Cache Augmentation demonstra claros benefícios em várias medições. Comparando-se com os LLMs tradicionais, os modelos augmented exibem melhorias notáveis em termos de latência e precisão em tarefas longas e complexas. Utilizando métricas como perplexidade e tempo de execução em benchmarks padronizados, os resultados indicam um salto significativo na eficiência sem comprometer a qualidade da inferência.

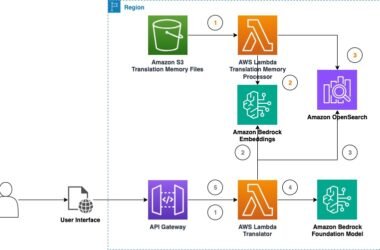

Aspectos Práticos

A implementação prática dessas inovações é um desafio significativo, mas totalmente possível dentro de um quadro bem estruturado. Para empresas brasileiras, o uso eficaz desses modelos pode significar desde melhorias em chatbots de atendimento até a otimização de análises de grandes volumes de dados textuais no setor de finanças. O foco deve ser em ajustar esses modelos às necessidades específicas e garantir que a integração dos mesmos respeite as leis e regulamentos de proteção de dados vigentes.

Considerações Técnicas

Ainda que os avanços sejam promissores, é crucial considerar os desafios e limitações técnicas. A complexidade dos modelos LLM exige uma infraestrutura computacional robusta e um grande volume de dados de treinamento de alta qualidade. Além disso, a ética na implementação destes sistemas não pode ser negligenciada, sendo essencial mitigar possíveis vieses que possam ser amplificados pelo uso desses modelos.

Recomendações de Uso

Para qualquer empresa ou desenvolvedor que busca implementar LLMs, é vital começar com pequenas aplicações experimentais para ajustar os modelos às suas necessidades únicas. Priorizar transparency e auditability será uma vantagem estratégica, especialmente em setores altamente regulados.

Pontos de Atenção

- Escolha da infraestrutura técnica adequada para treinamento e execução.

- Monitoramento contínuo da performance e ajuste de parâmetros.

- Mitigação de tendências ou vieses nos dados de treinamento.

- Otimização contínua baseada em feedback iterativo.

- Planejamento para atualizações e manutenção regular do modelo.

“Os LLMs aprimorados com co-processadores como o Differentiable Cache Augmentation não só melhoram a eficiência mas estabelecem um novo patamar para a compreensão contextual em larga escala. Como observa o Instituto Brasileiro de Inteligência Artificial, tal tecnologia representa uma reviravolta na capacidade de solução de problemas complexos pelas máquinas.” – Felipe Rodrigues