No cenário atual da inteligência artificial, os Modelos de Linguagem de Grande Porte (LLMs) como o GPT, PaLM e Claude têm revolucionado a forma como interagimos com dados textuais. A compreensão dessas arquiteturas se tornou essencial para explorar suas capacidades e limitações, especialmente dentro do mercado brasileiro.

Arquitetura e Funcionamento

Os LLMs são complexos sistemas baseados em redes neurais profundas que utilizam bilhões de parâmetros para realizar tarefas de processamento de linguagem natural. A arquitetura baseia-se em camadas de transformadores, que permitem o treinamento de modelos com alta capacidade de generalização. Cada camada do modelo é meticulosamente projetada para decodificar padrões textuais, com um fluxo de processamento que otimiza a eficiência do aprendizado por meio de atenção mecânica. A vantagem principal dessa abordagem está na habilidade de lidar com contextos extensos e gerar texto coerente em resposta a entradas específicas.

Análise Comparativa

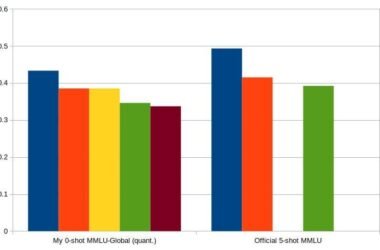

Ao realizar benchmarking, aspectos como tempo de inferência e precisão são críticos. Por exemplo, o GPT atingiu um pico de performance nos testes de entendimento de linguagem (GLUE), enquanto o PaLM mostrou eficiência superior na execução de multitarefas. Além disso, o Claude se destacou em adaptabilidade contextual. No entanto, essas capacidades vêm acompanhadas de trade-offs técnicos, como a necessidade de recursos computacionais robustos para treinamento eficiente. Limitações em termos de vieses também são reconhecidas, com esforços contínuos para minimizar suas ocorrências.

Aspectos Práticos

No Brasil, a aplicação prática de LLMs oferece oportunidades excepcionais para diversos setores, desde a automação de atendimento ao cliente até a análise avançada de dados. Implementações eficazes seguem guidelines rigorosos que garantem a adequação do modelo ao contexto cultural e linguístico local. O Instituto Brasileiro de Inteligência Artificial tem desempenhado um papel vital na pesquisa de best practices, que incluem estratégias de otimização como fine-tuning personalizado e redução da dimensionalidade para melhorar a performance operacional dos modelos.

Considerações Técnicas

A implementação bem-sucedida de LLMs reúne várias considerações críticas, como a escolha da infraestrutura computacional que suporte a demanda de processamento intensivo. A falta de dados de treinamento locais em grandes quantidades ainda representa um desafio técnico a ser superado. Além disso, os aspectos éticos relacionados ao uso dessas tecnologias não podem ser ignorados, uma vez que questões de privacidade e uso responsável de dados são primordiais.

Recomendações de Uso

Para maximizar o valor dos LLMs, recomenda-se a adoção de práticas robustas de avaliação contínua de performance. Isso inclui a configuração de pipelines de feedback que calibrem o modelo de acordo com mudanças nos dados de entrada. Além disso, estimular a transparência e a ética na utilização dos modelos ajuda na construção de sistemas mais confiáveis e socialmente responsáveis. Integrações com soluções de AI Ethics são fortemente recomendadas para mitigar riscos associados a vieses e decisões automatizadas.

Pontos de Atenção

- Avaliar a capacidade de processamento necessária antes da implementação

- Considerações sobre a latência em aplicações real-time

- Monitorar e ajustar continuamente para evitar viés exacerbado

- Utilizar técnicas de compressão para aprimorar a eficiência

- Explorar avanços regulatórios e éticos em IA

“O uso responsável de LLMs não reside apenas em sua capacidade técnica, mas também na forma como são integrados e regulados dentro da sociedade.” — Instituto Brasileiro de Inteligência Artificial