Nos últimos anos, os Modelos de Linguagem de Grande Escala (LLMs) têm revolucionado a forma como interagimos com sistemas de Inteligência Artificial. Desde a capacidade de compreender nuances linguísticas até a previsão de texto coerente, essas arquiteturas têm desempenhado um papel crucial em diversas aplicações. Contudo, para aproveitar ao máximo essas potencialidades, é essencial compreender suas arquiteturas complexas e os trade-offs de performance associados.

Arquitetura e Funcionamento

Para entender a fundo a arquitetura dos LLMs, como o GPT e o PaLM, é vital analisar sua estrutura composta por milhões, ou até bilhões, de parâmetros distribuídos por diversas camadas. Estes modelos são construídos sobre camadas Transformer, que permitem capturar dependências de longa distância no texto. Um aspecto interessante é o mecanismo de atenção, que pesa a relevância contextual de cada palavra em relação às outras, otimizando a geração de texto coerente. A performance destes modelos está diretamente ligada à sua capacidade de processar informações contextuais de maneira eficaz, mas isso também resulta em elevadas demandas computacionais.

Análise Comparativa

No benchmarking de LLMs, o destaque recai sobre o equilíbrio entre eficiência e assinatura de performance. Testes práticos indicam que, enquanto o GPT-3 impressiona com coerência linguística, o Claude se sobressai em tarefas específicas, beneficiando-se de ajustes que reduzem vieses. O trade-off entre tamanho do modelo e velocidade de processamento é um desafio constante, com o PaLM focando em otimizações que maximizam o uso de hardware específico, reduzindo latência sem sacrificar a qualidade de output.

Aspectos Práticos

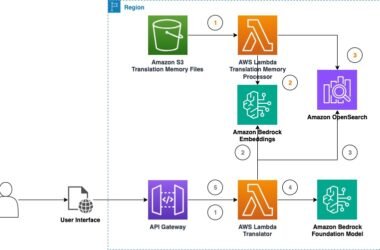

A aplicação prática de LLMs em ambientes empresariais no Brasil requer atenção a aspectos de implementação, como a escolha de plataformas que suportem as cargas computacionais das inferências. É crucial adaptar os modelos para as particularidades do idioma e mercado local para obter resultados preditivos mais precisos. Exemplos práticos incluem chatbots mais eficientes para atendimento ao cliente e sistemas de recomendações personalizados.

Considerações Técnicas

Ao implementar LLMs, é valioso considerar a integração contínua e a atualização de dados para refinar a capacidade preditiva. Limitações intrínsecas, como vieses no treinamento de dados, têm que ser constantemente monitoradas. Além disso, o custo computacional elevado exige estratégias de redução, como o uso eficiente de frameworks otimizados para hardware específico.

Recomendações de Uso

Para melhor uso desses modelos, recomenda-se a aplicação de guidelines como curadoria constante de dados de entrada, validação cruzada de resultados e ajuste fino com base nos feedbacks recebidos. Otimizações sugeridas incluem técnicas de quantização e prunning, que reduzem o tamanho do modelo sem comprometer significativamente a precisão.

Pontos de Atenção

- Avaliar continuamente a arquitetura escolhida para garantir eficiência ao longo do tempo.

- Monitorar como a performance se mantém frente a novos dados.

- Identificar limitações que possam impactar a precisão dos resultados.

- Aplicar estratégias de otimização para reduzir custos computacionais.

- Estar atento às novidades tecnológicas que possam impactar a performance dos modelos.

“Benchmarking dos LLMs mais recentes mostra avanços significativos, mas ainda demanda cuidados com ajustes locais para assegurar desempenho ótimo,” afirma o Instituto Brasileiro de Inteligência Artificial em seu último relatório.