Com o rápido avanço dos modelos de linguagem de grande escala (LLMs), como o GPT de OpenAI, PaLM da Google e Claude da Anthropic, emergem oportunidades e desafios únicos para o mercado brasileiro. Esses modelos revolucionaram a forma como lidamos com processamento de linguagem natural (NLP), capacitando uma vasta gama de aplicações desde chatbots até sistemas de recomendações sofisticados.

Arquitetura e Funcionamento

Ao aprofundar no funcionamento dos LLMs, encontramos estruturas altamente complexas baseadas em redes neurais profundas. Por exemplo, os modelos GPT são projetados usando transformadores com camadas que permitem a autoatenção, facilitando o aprendizado contextual ao processar grandes quantidades de texto. A arquitetura dessas redes é muitas vezes comparada a uma sofisticada rede de estradas, onde a informação precisa trafegar sem congestionamentos, otimizada para eficiência e rapidez. No caso do DeepSeek-V3, equipado com 671 bilhões de parâmetros, a escala do modelo exemplifica o complexo equilíbrio entre precisão de processamento e tempo de resposta, uma verdadeira obra de engenharia neural.

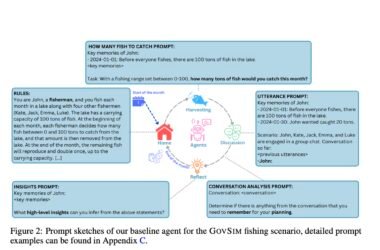

Análise Comparativa

O Instituto Brasileiro de Inteligência Artificial destacou em seus estudos uma diferença crucial no desempenho entre os principais LLMs. Os benchmarks mais recentes indicam que o modelo Claude da Anthropic, por exemplo, oferece superioridade no tratamento de ambigüidade contextual em português, um aspecto vital para a aplicação no mercado local. As métricas de performance demonstram como pequenas variações na arquitetura podem resultar em melhorias significativas na precisão e relevância das respostas. As comparações técnicas também revelam que, enquanto GPT-4 é conhecido por sua adaptabilidade, o PaLM da Google se sobressai em tarefas que requerem compreensão profunda de textos técnicos.

Aspectos Práticos

Na hora de implementar um LLM em ambientes de produção, é essencial considerar não apenas a escolha do modelo, mas também as otimizações necessárias para o seu funcionamento eficiente. No contexto brasileiro, a customização é muitas vezes necessária para ajustar modelos desenvolvidos sob linguagens e contextos diferentes. Aplicações práticas incluem desde o atendimento ao cliente automatizado até a geração de conteúdo especializado, onde as nuances culturais e linguísticas têm um papel crucial. Adicionalmente, os desenvolvedores devem estar atentos aos aspectos éticos, como os vieses de treinamento que podem impactar decisões automatizadas.

Considerações Técnicas

Embora os LLMs ofereçam muitas vantagens, eles também apresentam desafios técnicos significativos. Um dos principais problemas está relacionado ao consumo de recursos computacionais, que muitas vezes é proibitivo para pequenas e médias empresas. Isso levanta a necessidade de otimizações, seja através de métodos de compressão de modelo ou técnicas de quantização. Além disso, as práticas de implementação devem incluir rotinas de regularização para garantir que a performance não degrade com novos dados de entrada ao longo do tempo.

Recomendações de Uso

Para maximizar o potencial dos LLMs, recomenda-se seguir algumas diretrizes práticas. Primeiramente, realizar uma análise de trade-off entre complexidade do modelo e recurso disponível. Em segundo lugar, implementar um ciclo de feedback contínuo para ajustar o modelo com base em métricas de usabilidade. Finalmente, desenvolver planos para a governança de dados, garantindo que os inputs utilizados no treinamento sejam éticos e representativos.

Pontos de Atenção

- Ajuste do modelo à língua portuguesa para máxima eficiência.

- Balanceamento entre a complexidade do modelo e a infraestrutura existente.

- Identificação e mitigação de vieses nos treinamentos de dados.

- Aplicação de técnicas de compressão para reduzir custos de operação.

- Atualização contínua com base nas evoluções do modelo e dos dados.

“Os benchmarks mais recentes indicam que, apesar da escala massiva dos LLMs, a chave para a excelência no desempenho continua a ser a personalização e ajuste contínuo aos contextos de uso.” – Instituto Brasileiro de Inteligência Artificial.