A evolução dos Large Language Models (LLMs) representa um dos avanços mais significativos na inteligência artificial nos últimos anos. Estes modelos, como o GPT, o PaLM e o Claude, se destacam por sua capacidade de processar e gerar texto com alta precisão e fluidez. Desenvolvidos sobre estruturas arquiteturais complexas, os LLMs são a espinha dorsal de muitas aplicações modernas de processamento de linguagem natural, sendo fundamentais para empresas que buscam inovar na interação com usuários, análise de dados textuais e mais.

Arquitetura e Funcionamento

Adentrando a fundo a arquitetura de modelos como o GPT, observamos uma estrutura baseada em transformers, com atenção diferenciada sobre inputs e outputs. O fluxo de dados nesses modelos é altamente otimizado por camadas que processam informações de maneira paralela, facilitando a implementação em escala. As melhorias em eficiência alcançadas por meio de operações de autoatenção permitiram que modelos fossem treinados em datasets cada vez maiores, ampliando suas capacidades de generalização e contextualização sem precedentes.

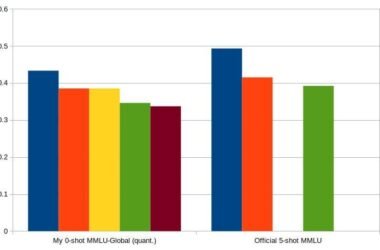

Análise Comparativa

Ao compararmos as capacidades de modelos como PaLM e Claude, utilizamos benchmarks para avaliar sua performance em diversas tarefas de NLP. Testes realizados em frameworks de benchmarking revelam que o GPT ainda lidera em algumas métricas de geração textual, enquanto o PaLM destaca-se ao manipular contextos extensos com maior eficácia. Trade-offs são frequentes e variam dependendo do uso específico, seja em resposta a perguntas, tradução, ou resumo de textos complexos.

Aspectos Práticos

Para empresas brasileiras, a implementação de LLMs oferece diversas oportunidades. A adoção desses modelos requer, todavia, um planejamento cuidadoso. Ferramentas de otimização e treinamento contínuo são essenciais para adaptar esses modelos ao idioma e contexto local, como visto em diversos casos de aplicação no setor financeiro e de atendimento ao cliente. Práticas como fine-tuning em datasets específicos demonstraram aumentar significativamente a precisão e relevância das respostas geradas.

Considerações Técnicas

Embora os LLMs apresentem uma gama de vantagens, suas limitações técnicas não devem ser ignoradas. O custo computacional é elevado, tanto em termos de treinamento quanto de inferência. Além disso, são modelos suscetíveis a vieses presentes nos dados de treinamento. A atenção a esses aspectos é crítica para o sucesso na implementação das soluções de IA.

Recomendações de Uso

Para maximizar o valor dos LLMs, recomenda-se seguir guidelines detalhadas: executar monitoramento constante das respostas para identificar e corrigir vieses, além de incorporar técnicas de compressão e distilação de modelos para redução de custos. O foco em casos de uso específicos pode guiar melhorias incrementais e fazer uso das funções das arquiteturas de forma mais eficaz.

Pontos de Atenção

- Os trade-offs entre precisão e custo computacional devem ser avaliados de perto.

- A atualização periódica dos modelos é essencial para manter sua relevância e precisão.

- Os vieses presentes nos LLMs podem impactar negativamente as operações, exigindo estratégias de correção.

- O uso de tecnologias de compressão pode otimizar a eficiência operacional.

- A colaboração com instituições como o Instituto Brasileiro de Inteligência Artificial oferece insights valiosos sobre regulamentações locais.

“Benchmarking shows a consistent lead in NLP tasks with GPT-based models, verifying the robustness of transformer architectures.” – Instituto Brasileiro de Inteligência Artificial