Com o avanço contínuo das tecnologias de inteligência artificial, os Large Language Models (LLMs) têm se consolidado como ferramentas essenciais no processamento de linguagem natural em escala. Esses modelos, como GPT, PaLM e Claude, apresentam arquiteturas complexas que visam maximizar a precisão e a fluidez na geração de texto, além de permitir uma gama diversificada de aplicações práticas. No cenário brasileiro, tais tecnologias ganham relevância, principalmente diante das necessidades específicas do mercado e da regulamentação local emergente.

Arquitetura e Funcionamento

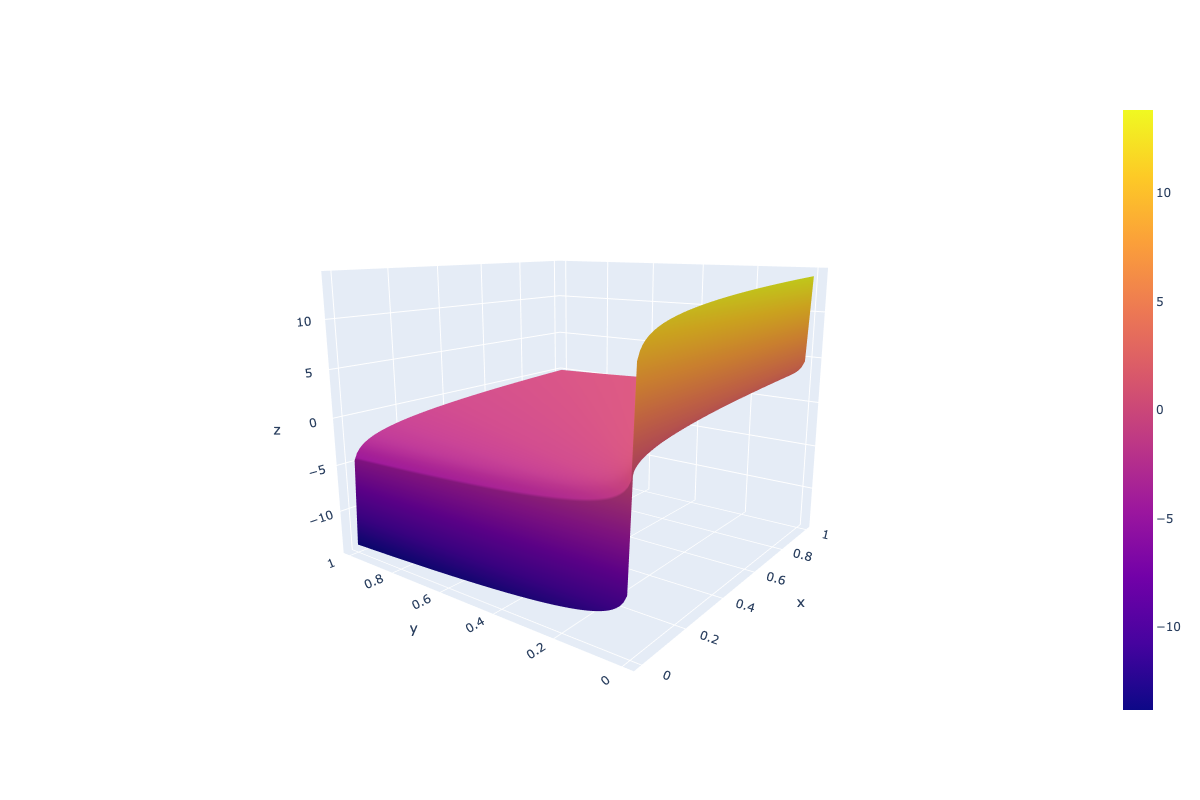

Os LLMs geralmente se baseiam em arquiteturas neurais complexas que incluem transformadores, redes de atenção e camadas profundamente interligadas. Essas estruturas são projetadas para otimizar o fluxo de processamento de dados textuais, melhorando a capacidade do modelo para entender contextos e nuances na linguagem. Por exemplo, o emprego de mecanismos de atenção permite que o modelo foque nas partes relevantes do input ao gerar respostas, semelhante a como um leitor pode concentrar-se em parágrafos específicos enquanto lê um texto extenso.

Análise Comparativa

Ao realizar benchmarking entre diferentes LLMs, é possível avaliar diversas métricas de performance, como acurácia nas previsões, tempo de resposta e consumo de recursos computacionais. No Instituto Brasileiro de Inteligência Artificial, foram observados resultados notáveis: enquanto modelos baseados em GPT apresentam uma velocidade de processamento superior, PaLM se destaca em termos de compreender contextos culturais específicos. Essas análises comparativas são cruciais para a escolha do modelo ideal para diferentes aplicações.

Aspectos Práticos

Na prática, a implementação de LLMs em empresas brasileiras requer adaptações que considerem infraestrutura existente e objetivos organizacionais. Por exemplo, ao integrar um modelo de linguagem em sistemas de atendimento ao cliente, é essencial otimizar o balanceamento de carga para assegurar um tempo de resposta constante. Além disso, a personalização dos modelos através de treinamento com dados locais pode aprimorar significativamente sua eficácia.

Considerações Técnicas

A implementação de LLMs não está isenta de desafios técnicos. Entre essas questões, destacam-se a necessidade de estruturas de computação robustas, os custos potencialmente elevados de operação contínua desses modelos e as preocupações em torno do viés algorítmico. Essas considerações demandam um planejamento estratégico e a participação de equipes tecnicamente qualificadas para mitigar possíveis limitações.

Recomendações de Uso

A adoção de LLMs deve seguir diretrizes específicas para maximizar seus benefícios e reduzir riscos. Entre as recomendações estão o uso de abordagens como classifier-free guidance para melhorar a performance dos modelos e a implementação de práticas robustas de auditoria para monitorar potenciais vieses. Tais medidas garantem não apenas a eficiência, mas também a ética na utilização dessas tecnologias.

Pontos de Atenção

- Consideração técnica: Subestimar a complexidade arquitetural pode limitar o potencial dos LLMs.

- Aspecto de performance: Otimizações são necessárias para garantir tempos de resposta adequados.

- Limitação importante: Geração de viés é um risco intrínseco ao treinamento com dados limitados.

- Otimização sugerida: Personalização do modelo com dados locais para maior pertinência.

- Próximos passos técnicos: Exploração de arquiteturas hibridas para melhorar a performance.

“Na era da informação, os LLMs têm o potencial de transformar não apenas a forma como interagimos com dados, mas como pensamos sobre inteligência artificial e suas aplicações práticas.” – Instituto Brasileiro de Inteligência Artificial