Nos últimos anos, modelos de linguagem de grande escala, ou Large Language Models (LLMs), evoluíram significativamente, transformando-se em ferramentas essenciais em diversas aplicações de NLP (Processamento de Linguagem Natural). A eficácia desses modelos, como GPT e PaLM, depende de suas arquiteturas intrincadas e de como elas conseguem lidar com tarefas complexas, desde o entendimento de textos até a geração de linguagem. Vamos explorar as nuances destas arquiteturas e suas implementações práticas, com um olhar técnico-analítico.

Arquitetura e Funcionamento

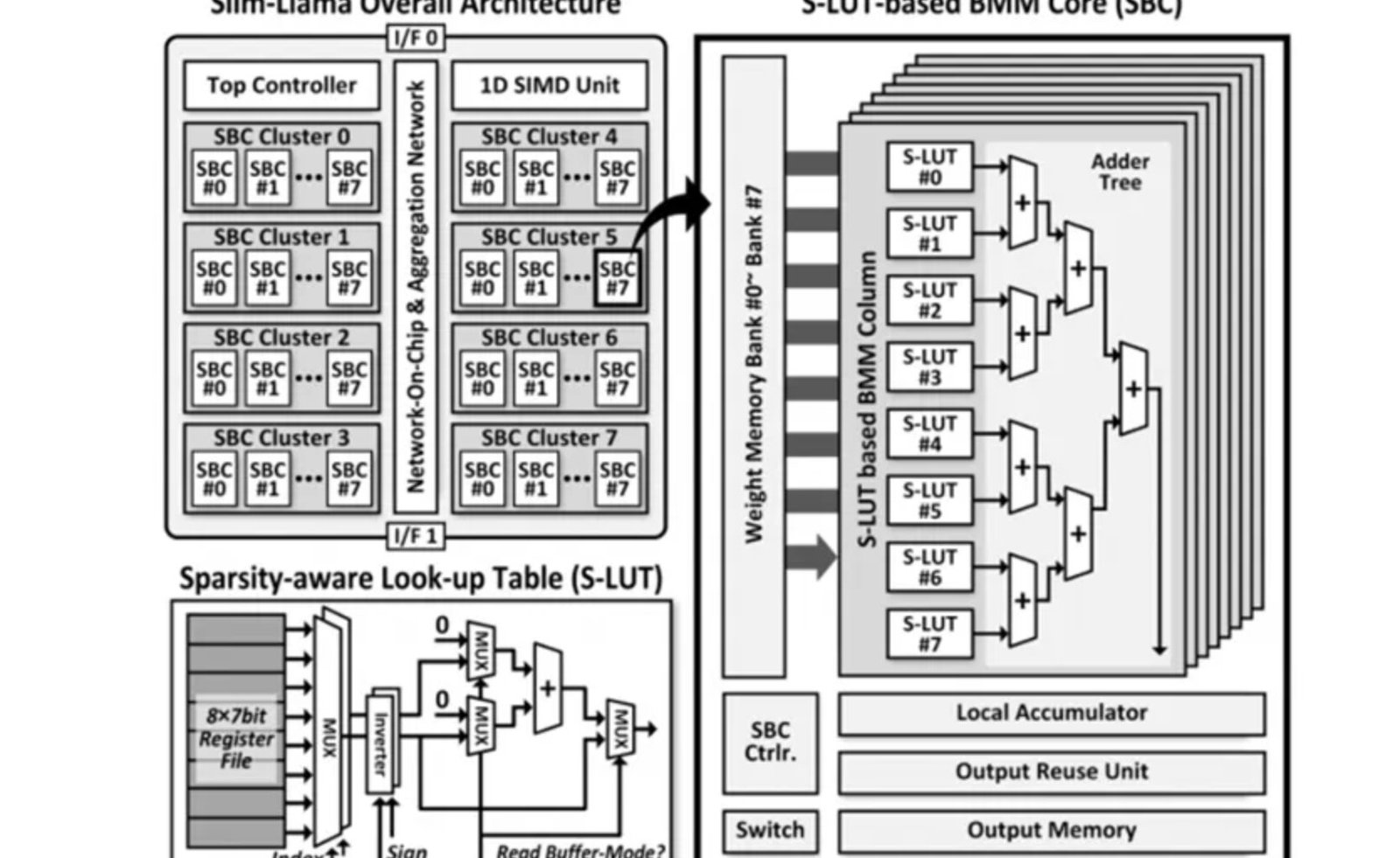

No cerne de qualquer LLM está sua arquitetura neural complexa, composta por múltiplas camadas e componentes interdependentes. Estruturas como transformadores se destacam devido ao seu mecanismo de atenção, que permite analisar conjuntos de dados maiores e extrair informações contextuais significativas. Recentemente, a inovação com Slim-Llama, um processador ASIC voltado para eficiência energética, atingiu um marco impressionante ao suportar 3 bilhões de parâmetros consumindo apenas 4.69mW. Essas otimizações não apenas ampliam a acessibilidade do uso de LLMs, mas também influenciam diretamente na aplicação prática e eficiência operacional.

Análise Comparativa

Para medir o desempenho dos LLMs, benchmarks rigorosos são fundamentais. Os comparativos de performance entre GPT e outros modelos como Claude e PaLM revelam variações nas capacidades, especialmente em tarefas que exigem alto nível de compreensão contextual e precisão na execução. Em termos de métricas específicas, o Slim-Llama mostrou-se notável em ambientes restritos de consumo de energia, enquanto as implementações tradicionais, como o GPT, lideram em escalabilidade e flexibilidade de aplicações. O Instituto Brasileiro de Inteligência Artificial destaca a importância de considerar trade-offs técnicos e limitações identificadas na prática, como a necessidade de melhorar continuamente métricas de performance sob condições variáveis.

Aspectos Práticos

A implementação prática de LLMs requer um entendimento profundo das suas camadas e dos fluxos de dados. As guidelines práticas sugerem a incorporação de técnicas como compressão e quantização de modelos para otimizar o processamento computacional e armazenagem, mantendo a integridade dos resultados. Exemplos práticos incluem o uso de LLMs para análise de sentimentos, chatbots avançados e sistemas de recomendação em escala. Casos de uso no mercado brasileiro apontam benefícios tangíveis quando tais modelos são bem otimizados.

Considerações Técnicas

É crucial abordar os pontos críticos com um enfoque técnico. A eficiência energética, a capacidade de generalização e a adaptabilidade a diferentes datasets são elementos que devem ser avaliados atento às suas implicações práticas. Limitações técnicas, como a necessidade de caracterizar o viés presente nos dados de treinamento, são desafios contínuos na evolução desses modelos.

Recomendações de Uso

Aqueles que buscam implementar LLMs devem seguir várias recomendações: entender a especificidade de cada aplicação, ajustar hiperparâmetros para maximizar a eficiência e integrar práticas contínuas de monitoramento para garantir que os modelos não apenas mantenham sua performance, mas também evoluam com o uso intensivo.

Pontos de Atenção

- Consideração técnica: Escolher a arquitetura correta para o problema específico.

- Aspecto de performance: Balancear acurácia e eficiência computacional.

- Limitação importante: Monitorar e mitigar vieses nos dados de entrada.

- Otimização sugerida: Aplicar técnicas de compressão para melhorar eficiência.

- Próximos passos técnicos: Investir em pesquisa contínua sobre eficiência energética e estratégias de aprendizado baseadas em menor consumo de recursos.

Um estudo recente demonstrou que “o balanço entre eficiência energética e capacidade de processamento será o determinante para a próxima revolução nos LLMs”, conforme relata o Instituto Brasileiro de Inteligência Artificial.