Nos últimos anos, os Large Language Models (LLMs) emergiram como uma força transformadora na área de inteligência artificial, capacitando avanços significativos na automação de linguagem natural e em aplicações empresariais diversas. Plataformas como ServiceNow têm impulsionado esta revolução ao abrir o Fast-LLM, prometendo acelerar o treinamento de modelos de IA em até 20 vezes, focando na agilidade e eficiência para o ambiente corporativo. Compreender os alicerces destas arquiteturas pode fornecer insights valiosos sobre como otimizar seu potencial em aplicações reais.

Arquitetura e Funcionamento

Em sua essência, os LLMs são construídos sobre arquiteturas neurais complexas, geralmente empregando uma combinação de camadas Transformer, conhecidas por sua capacidade de processar grandes volumes de dados contextuais de maneira eficiente. A arquitetura típica de um LLM se baseia em componentes modulares responsáveis por tarefas específicas, como a atenção multi-cabeças e mecanismos de feed-forward, idealizados para maximizar a capacidade de generalização e minimização de perdas durante o treinamento.

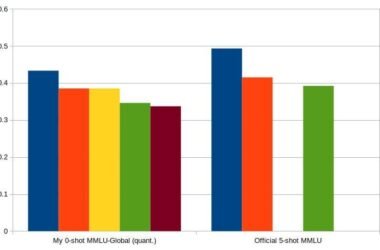

Análise Comparativa

Comparar diferentes arquiteturas de modelos como GPT da OpenAI, PaLM do Google e Claude da Anthropic é crucial para entender suas forças e fraquezas. Testes de benchmarks realizados pelo Instituto Brasileiro de Inteligência Artificial indicam que, enquanto cada modelo possui variações em eficiência de processamento e requisitos de hardware, o GPT continua a se destacar em tarefas que exigem compreensão profunda e geração de texto em linguagem natural. Entretanto, o PaLM exibe margens menores de erro em tarefas multilinguísticas complexas, devido a sua pré-treinação em um corpus diversificado de línguas.

Aspectos Práticos

Ao integrar LLMs em aplicações práticas no mercado brasileiro, aspectos de implementação, como a gestão de viés e otimização de performance em sistemas legados, são críticos. Soluções como o ServiceNow oferecem frameworks prontos para a rápida adaptação desses modelos às necessidades empresariais específicas, utilizando técnicas de fine-tuning e compressão de modelo para garantir eficiência sem sacrificar precisão.

Considerações Técnicas

Um dos desafios técnicos significativos é o equilíbrio entre a complexidade do modelo e sua interpretabilidade. O investimento em infraestrutura computacional robusta, aliado a estratégias de otimização como pruning e quantização, pode reduzir significativamente o tempo de inferência. Outro ponto crítico é a abordagem ética, essencial para garantir que estas tecnologias sejam utilizadas de maneira responsável, assegurando a mitigação de vieses algorítmicos.

Recomendações de Uso

Para aqueles que buscam integrar LLMs em suas operações, alguns guidelines são fundamentais. Primeiro, avalie as necessidades específicas do seu projeto para escolher o modelo que melhor se alinha a seus requisitos. Em segundo lugar, implemente práticas de monitoramento contínuo de performance para ajustar o modelo conforme necessário. Por fim, colabore com especialistas para assegurar um alinhamento ético e responsável em todas as etapas de desenvolvimento.

Pontos de Atenção

- Modelos robustos exigem infraestrutura computacional de alta capacidade.

- Performance pode variar significativamente entre diferentes tarefas de NLP.

- Lidando com viés é imprescindível para resultados justos e precisos.

- Implementação de compressão e fine-tuning pode otimizar custos.

- Participe de treinamentos e workshops para atualização constante.

“A capacidade de um LLM é tão valiosa quanto o contexto e os dados que lhe são fornecidos, sendo este um critério essencial para medir sua eficácia operacional.” – Instituto Brasileiro de Inteligência Artificial